[ML Study Jams Vol.4] GSP013 AIプラットホームでの TensorFlow による赤ちゃんの体重予測 受講メモ

GSP013 AIプラットホームでの TensorFlow による赤ちゃんの体重予測

https://www.qwiklabs.com/focuses/607

受講準備

- Qwiklabs コーステキストを読みます。

- ハンズオンではなく実際のシーンでは、分析データと、必要なデータを BigQuery から CSV にエクスポートする Dataflow コードが必要。

https://github.com/GoogleCloudPlatform/training-data-analyst/blob/master/blogs/babyweight/babyweight.ipynb - ハンズオンでは前述の dataflow コードを用いず前処理したデータセットをバケツ格納するところから始まることを認識しておく。

- コーステキストを読むと、赤ちゃんの体重予測をするというよりも「Cloud Datalab で機械学習モデルをトレーニング、評価、デプロイする方法」ではなく、その体験といった感じ。

- きちんと理解するには、JupyterLab train_deploy.ipynb を実行しよう。

概要

このラボでは、機械学習モデルをトレーニング、評価、展開して、赤ちゃんの体重を予測します。次に、モデルにリクエストを送信してオンライン予測を行います。

このラボの内容:

- Al プラットホーム ノートブックを起動します

- ローカル トレーニングを行う

- 分散トレーニングを行う

- ML モデルをウェブサービスとしてデプロイする

- モデルを使って予測を行う

(qwiklabs から引用)

ハンズオンの内容メモ

■前処理したデータセットをバケツ格納するコピー速度が約 400 MiB/s (メガビイト毎秒)なので、 3.2 Gbps の高速に驚いた。

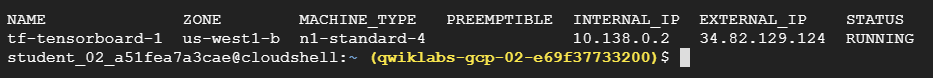

■ Cloud AI Platform Notebook インスタンス(TensorBoard 対応)アップしたところ。

■ Notebook Terminal から git clone したが、転送速度はあまり早くない。

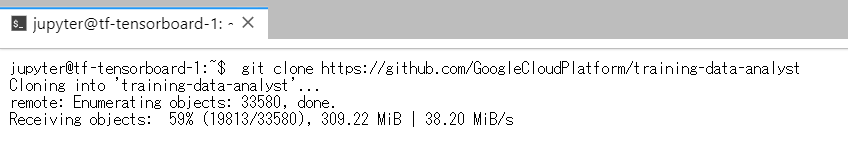

■ Notebook で実装を終えたのでグラフ構造を見てみた。(大きい 1/2)

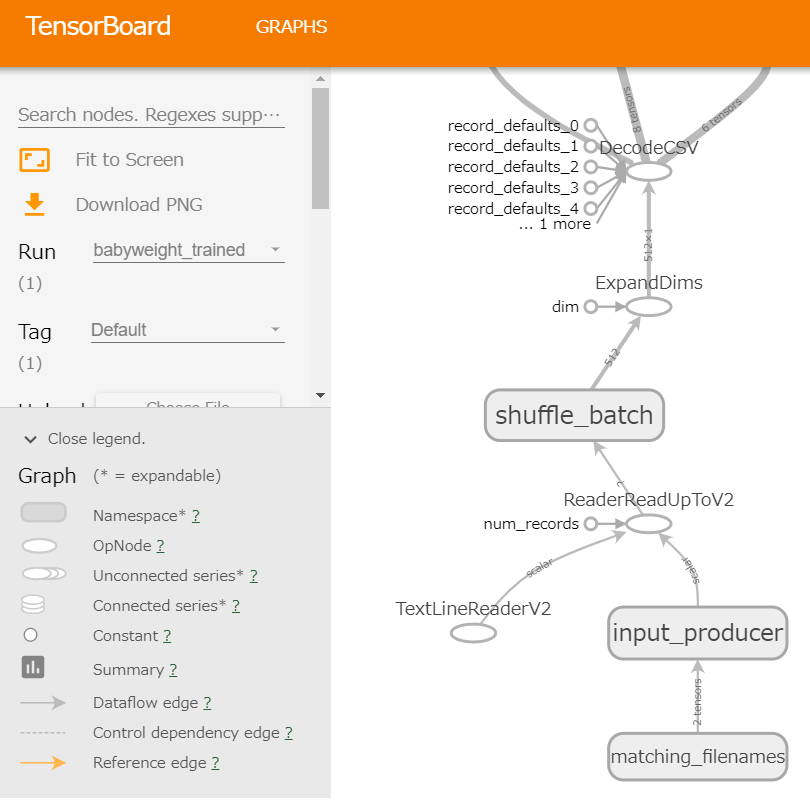

■ Notebook で実装を終えたのでグラフ構造を見てみた。(大きい 2/2)

■ head / サブグラフ 270 ノード

■ head/Adagrad サブグラフ 12 ノード

ラボ終了

Cloud Datalab で機械学習モデルをトレーニング、評価、デプロイする方法が分かりました。

このコマ終了に要した時間は 70分 ほど。

ご覧いただき有難うございました。

以上

![[資格取得] IBM Cloud for Professional Architect v6 (合格体験談)](https://www.fxfrog.com/wp-content/themes/newscrunch/assets/images/no-preview.jpg)